- Pengarang Lynn Donovan [email protected].

- Public 2023-12-15 23:51.

- Diubah suai terakhir 2025-01-22 17:34.

Mulakan Percikan api Kuasai berbilang nod dan pastikan nod ini mempunyai nod yang sama Penjaga zoo konfigurasi untuk Penjaga zoo URL dan direktori.

Maklumat.

| Harta sistem | Maknanya |

|---|---|

| percikan api .deploy. penjaga zoo .dir | Direktori dalam Penjaga zoo untuk menyimpan keadaan pemulihan (lalai: / percikan api ). Ini boleh menjadi pilihan |

Daripada itu, bolehkah anda menjalankan percikan secara tempatan?

Percikan boleh jadilah lari menggunakan penjadual kluster kendiri terbina dalam dalam tempatan mod. Ini bermakna bahawa semua Percikan api proses adalah lari dalam JVM yang sama secara berkesan, satu contoh berbilang benang Percikan api.

Kedua, bolehkah Spark digunakan tanpa Hadoop? Seperti yang diper Percikan api dokumentasi, Spark boleh lari tanpa Hadoop . Anda boleh menjalankannya sebagai mod Kendiri tanpa mana-mana pengurus sumber. Tetapi jika anda ingin menjalankan dalam persediaan berbilang nod, anda memerlukan pengurus sumber seperti YARN atau Mesos dan sistem fail yang diedarkan seperti HDFS , S3 dsb. Ya, percikan api boleh lari tanpa hadoop.

Juga perlu diketahui, mengapa ZooKeeper digunakan dalam Hadoop?

Penjaga zoo dalam Hadoop boleh dilihat sebagai repositori berpusat di mana aplikasi yang diedarkan boleh meletakkan data dan mendapatkan data daripadanya. Ia adalah digunakan untuk memastikan sistem teragih berfungsi bersama sebagai satu unit, menggunakan penyegerakan, penyelarasan dan matlamat penyelarasannya.

Bagaimanakah percikan kendiri berfungsi?

Berdiri sendiri mod ialah pengurus kluster mudah yang digabungkan dengan Percikan api . Ia memudahkan untuk menyediakan kluster itu Percikan api sendiri mengurus dan boleh berjalan pada Linux, Windows atau Mac OSX. Selalunya ia adalah cara paling mudah untuk dijalankan Percikan api aplikasi dalam persekitaran berkelompok. Belajar, cara memasang Apache Spark hidup Berdiri sendiri Mod.

Disyorkan:

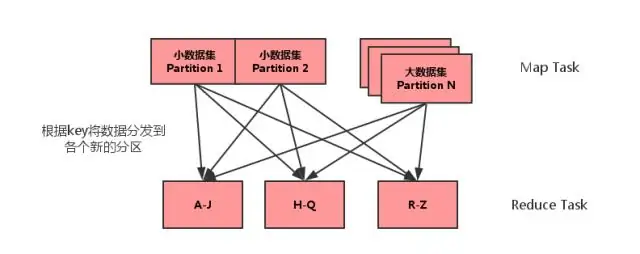

Apakah gabungan sebelah MAP dalam percikan?

Cantuman sisi peta ialah proses di mana cantuman antara dua jadual dilakukan dalam fasa Peta tanpa penglibatan fasa Kurangkan. Cantuman Sisi Peta membolehkan jadual dimuatkan ke dalam memori memastikan operasi cantum yang sangat pantas, dilakukan sepenuhnya dalam pemeta dan itu juga tanpa perlu menggunakan kedua-dua peta dan mengurangkan fasa

Adakah saya perlu belajar Hadoop untuk percikan api?

Tidak, anda tidak perlu belajar Hadoop untuk belajarSpark. Spark adalah projek bebas. Tetapi selepas YARNand Hadoop 2.0, Spark menjadi popular keranaSpark boleh berjalan di atas HDFS bersama-sama dengan komponen Hadoop yang lain. Hadoop ialah rangka kerja di mana anda menulisMapReduce kerja dengan mewarisi kelas Java

Di manakah saya boleh mencari log percikan?

Direktori log Lokasi SPARK_WORKER_LOG_DIR lalai ialah /var/log/spark/worker. Direktori log lalai untuk memulakan pelayan Spark SQL Thrift ialah $HOME/spark-thrift-server. Spark Shell dan log aplikasi adalah output kepada konsol. Fail konfigurasi log terletak dalam direktori yang sama seperti spark-env.sh

Adakah pertunjukan adalah aksi dalam percikan api?

2 Jawapan. persembahan memang aksi, tetapi ia cukup bijak untuk mengetahui apabila ia tidak perlu menjalankan segala-galanya. Jika anda mempunyai orderBy, ia akan mengambil masa yang sangat lama juga, tetapi dalam kes ini semua operasi anda adalah operasi peta dan jadi tidak perlu mengira keseluruhan jadual akhir

Apakah maksud percikan api?

Spark ialah enjin pemprosesan data teragih tujuan umum yang sesuai untuk digunakan dalam pelbagai keadaan. Di atas enjin pemprosesan data teras Spark, terdapat perpustakaan untuk SQL, pembelajaran mesin, pengiraan graf dan pemprosesan strim, yang boleh digunakan bersama dalam aplikasi