Isi kandungan:

- Pengarang Lynn Donovan donovan@answers-technology.com.

- Public 2023-12-15 23:51.

- Diubah suai terakhir 2025-01-22 17:34.

Kumpul (Tindakan) - Kembalikan semua elemen set data sebagai tatasusunan pada program pemacu. Ini biasanya berguna selepas penapis atau operasi lain yang mengembalikan subset data yang cukup kecil.

Dengan cara ini, apakah itu PySpark?

PySpark Pengaturcaraan. PySpark ialah kerjasama Apache Spark dan Python. Apache Spark ialah rangka kerja pengkomputeran kluster sumber terbuka, dibina berdasarkan kelajuan, kemudahan penggunaan dan analisis penstriman manakala Python ialah bahasa pengaturcaraan peringkat tinggi tujuan umum.

Juga, apakah peta dalam PySpark? Percikan api Peta Transformasi. A peta ialah operasi transformasi dalam Apache Spark. Ia digunakan untuk setiap elemen RDD dan ia mengembalikan hasilnya sebagai RDD baharu. Peta menukar RDD panjang N kepada RDD panjang N yang lain. RDD input dan output biasanya akan mempunyai bilangan rekod yang sama.

Dengan cara ini, apakah itu SparkContext dalam PySpark?

PySpark - SparkContext . Iklan. SparkContext adalah pintu masuk kepada mana-mana percikan api kefungsian. Apabila kita menjalankan apa-apa Percikan api aplikasi, program pemacu bermula, yang mempunyai fungsi utama dan anda SparkContext dimulakan di sini. Program pemacu kemudian menjalankan operasi di dalam pelaksana pada nod pekerja.

Bagaimanakah cara saya menyemak versi PySpark?

2 Jawapan

- Buka Terminal shell Spark dan masukkan arahan.

- sc.version Atau spark-submit --version.

- Cara paling mudah ialah dengan hanya melancarkan "spark-shell" dalam baris arahan. Ia akan memaparkan.

- versi aktif semasa Spark.

Disyorkan:

Apakah w3c apakah Whatwg?

Kumpulan Kerja Teknologi Aplikasi Hiperteks Web (WHATWG) ialah komuniti orang yang berminat dalam HTML yang berkembang dan teknologi yang berkaitan. WHATWG diasaskan oleh individu daripada Apple Inc., Yayasan Mozilla dan Perisian Opera, vendor penyemak imbas Web terkemuka, pada tahun 2004

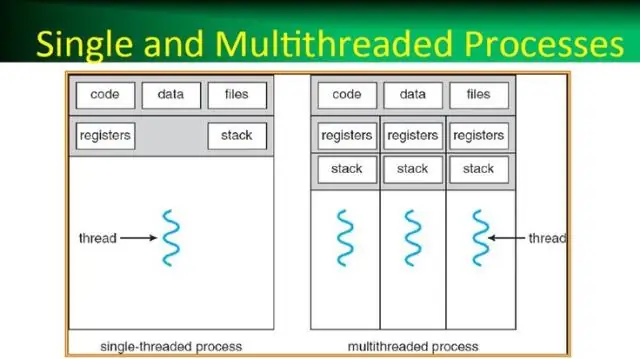

Apakah proses dalam sistem pengendalian apakah benang dalam sistem pengendalian?

Proses, dalam istilah yang paling mudah, ialah program pelaksana. Satu atau lebih utas dijalankan dalam konteks proses. Benang ialah unit asas yang sistem pengendalian memperuntukkan masa pemproses. Benang benang digunakan terutamanya untuk mengurangkan bilangan benang aplikasi dan menyediakan pengurusan benang pekerja

Apakah rujukan sel dan apakah jenis rujukan yang berbeza?

Terdapat dua jenis rujukan sel: relatif dan mutlak. Rujukan relatif dan mutlak berkelakuan berbeza apabila disalin dan diisi ke sel lain. Rujukan relatif berubah apabila formula disalin ke sel lain. Rujukan mutlak, sebaliknya, kekal berterusan tidak kira di mana ia disalin

Bagaimanakah cara saya membuat PySpark DataFrame daripada senarai?

Saya mengikuti langkah-langkah ini untuk mencipta DataFrame daripada senarai tupel: Buat senarai tupel. Setiap tuple mengandungi nama seseorang yang mempunyai umur. Buat RDD daripada senarai di atas. Tukar setiap tupel kepada baris. Buat DataFrame dengan menggunakan createDataFrame pada RDD dengan bantuan sqlContext

Apakah baris dalam PySpark?

Satu baris dalam SchemaRDD. Medan di dalamnya boleh diakses seperti atribut. Baris boleh digunakan untuk mencipta objek baris dengan menggunakan argumen bernama, medan akan diisih mengikut nama