- Pengarang Lynn Donovan donovan@answers-technology.com.

- Public 2023-12-15 23:51.

- Diubah suai terakhir 2025-01-22 17:34.

manakala Percikan api menyokong pemuatan fail daripada tempatan sistem fail, ia memerlukan bahawa fail tersedia pada laluan yang sama pada semua nod dalam kelompok anda. Sesetengah sistem fail rangkaian, seperti NFS, AFS dan lapisan NFS MapR, terdedah kepada pengguna sebagai sistem fail biasa.

Selepas itu, seseorang juga mungkin bertanya, bagaimana cara saya menjalankan percikan dalam mod tempatan?

Dalam mod tempatan , percikan api pekerjaan lari pada mesin tunggal, dan dilaksanakan secara selari menggunakan berbilang benang: ini mengehadkan keselarian kepada (paling banyak) bilangan teras dalam mesin anda. Kepada lari pekerjaan di mod tempatan , anda perlu menempah mesin terlebih dahulu melalui SLURM secara interaktif mod dan log masuk ke dalamnya.

Selain di atas, apakah SC textFile? Fail teks adalah kaedah org. apache. SparkContext kelas yang membaca a fail teks daripada HDFS, sistem fail tempatan (tersedia pada semua nod), atau mana-mana URI sistem fail yang disokong Hadoop, dan mengembalikannya sebagai RDD Strings.

Dalam hal ini, apakah itu fail percikan?

The Fail Spark ialah dokumen di mana anda menyimpan semua kebaikan kreatif anda. Ia ditakrifkan oleh pengarang Stephen Johnson. Jadi daripada menconteng nota pada Post-it® pada tengah malam atau menumpukan jurnal yang berbeza untuk idea, anda meletakkan semua konsep anda dalam satu fail.

Apakah percikan koleksi selari?

Kami menerangkan operasi pada set data yang diedarkan kemudian. Koleksi selari dicipta dengan memanggil JavaSparkContext 's selarikan kaedah pada sedia ada Koleksi dalam program pemandu anda. Unsur-unsur yang koleksi disalin untuk membentuk set data teragih yang boleh dikendalikan secara selari.

Disyorkan:

Bolehkah Python membaca fail ZIP?

Untuk bekerja pada fail zip menggunakan python, kami akan menggunakan modul python terbina yang dipanggil zipfile. print ('Done!' ZipFile ialah kelas modul zipfile untuk membaca dan menulis fail zip. Di sini kami mengimport hanya kelas ZipFile daripada modul zipfile

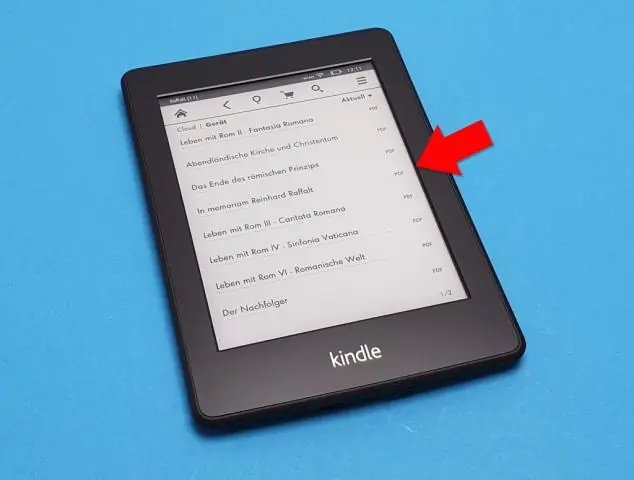

Bolehkah akhir membaca fail PDF?

Petua pro: Anda juga boleh membuka fail dalam Akhir dengan memilih fail dalam pencari anda dan mengklik kanan. Kemudian pilih “Buka dengan…” dan pilih Akhir dalam bar program. tahniah! Anda telah berjaya mengimport fail PDF ke Finale menggunakanScanScore

Bolehkah nook membaca fail PDF?

Dokumen yang boleh anda tambahkan pada PDF Nookinclude, yang boleh berupa buku atau dokumen lain yang lebih pendek. PDF di Nook boleh dibaca sama seperti buku lain yang dibeli dan anda boleh menyegerakkan peranti, menyalin dokumen daripada komputer anda ke Nook. Klik dua kali pada folder "Buku" atau "Dokumen" pada pemacu Nook anda

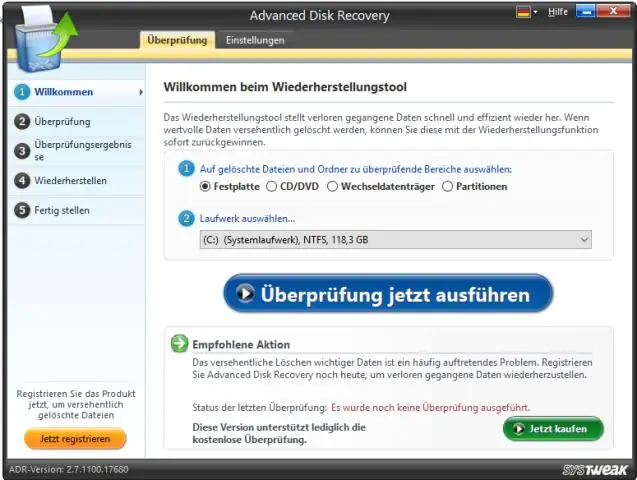

Bolehkah Windows 10 membaca fail mentah?

Windows 10 tidak dihantar dengan sokongan asli untuk pratonton fail imej mentah, bermakna pengguna tidak boleh melihat lakaran kecil atau metadata dalam Photos appor Windows File Explorer. Microsoft mempunyai penyelesaian untuk jurugambar yang memerlukan keupayaan ini, bagaimanapun, dan ia dipanggil Sambungan Imej Mentah

Bolehkah saya menjalankan spark secara tempatan?

Spark boleh dijalankan menggunakan penjadual kluster kendiri terbina dalam dalam mod tempatan. Ini bermakna semua proses Spark dijalankan dalam JVM yang sama secara berkesan, satu contoh berbilang benang Spark